Почему уменьшается страница после поиска яндекс просмотреть.

Индексирующий робот Яндекса регулярно обходит страницы сайтов и загружает их в поисковую базу. При этом робот может загрузить не все нужные вам страницы из-за их недоступности.

Яндекс.Вебмастер позволяет узнать, какие страницы вашего сайта обходит робот и выявить адреса страниц, которые робот не смог загрузить из-за недоступности сервера, на котором находится сайт, или из-за ошибок в содержимом самих страниц.

Данные о страницах доступны в Яндекс.Вебмастере на странице Индексирование → Статистика обхода . Информация обновляется ежедневно в течение шести часов с момента посещения страниц роботом.

По умолчанию сервис предоставляет данные по сайту в целом. Чтобы просмотреть информацию о конкретном разделе, выберите его из списка в поле с адресом сайта. Доступные разделы соответствуют структуре сайта, известной Яндексу (кроме разделов, добавленных вручную).

Если в списке не все страницы, которые должны участвовать в поиске, сообщите о них с помощью инструмента Переобход страниц .

Информацию о страницах можно выгрузить в формате XLS или CSV с учетом примененных фильтров .

- Динамика состояния страниц

- Фильтрация данных

Динамика состояния страниц

Информация о страницах представлена следующим образом:

- Новые и изменившиеся - количество страниц, которые робот обошел впервые, и страниц, статус которых изменился после очередного обращения к ним робота.

- История обхода - количество страниц, которые робот обошел, с учетом кода ответа сервера.

Изменения страниц в поисковой базе

Чтобы просмотреть изменения, установите переключатель в положение Последние изменения . В результате отобразится до 50 000 изменений.

Вебмастер показывает следующие сведения о страницах:

- код ответа сервера, полученный роботом при посещении страницы.

Основываясь на этой информации, можно узнать, как часто робот обходит страницы сайта, а также понять, какие страницы только появились в базе робота, а к каким робот обращается повторно.

Появление страницы в поисковой базе

Для страницы, которую робот обошел впервые, в столбце Было отображается статус N/a, а в столбце Стало - ответ сервера (например, 200 OK).

После успешной загрузки в поисковую базу страница может появиться в результатах поиска с ближайшими обновлениями поисковой базы. Информация о ней становится доступна в разделе Страницы в поиске .

Повторное обращение робота к странице

Если робот ранее обошел страницу, то при повторном обращении к ней статус может измениться: в столбце Было отображается ответ сервера, полученный во время предыдущего посещения робота, в столбце Стало - ответ сервера, полученный при последнем обращении.

Например, участвующая в поиске страница стала недоступна для робота. В этом случае она исключается из поиска. Через некоторое время после этого ее можно увидеть в списке исключенных в разделе Страницы в поиске .

Удаленная из поиска страница еще может оставаться в поисковой базе для проверки ее доступности. Как правило, робот продолжает обращаться к такой странице, пока на нее ведут ссылки или она не закрыта в файле robots.txt .

Список страниц, которые обошел робот

Чтобы увидеть список страниц, установите переключатель в положение Все страницы . Список может содержать до 50 000 страниц сайта.

Вы можете просмотреть список страниц сайта, которые обошел робот, и следующую информацию о них:

- дата последнего посещения страницы роботом (дата обхода);

- адрес страницы относительно корневого каталога сайта;

- код ответа сервера при последней загрузке страницы роботом.

Совет. Если в списке отображаются страницы, которые уже удалены с сайта или не существуют, вероятно, робот находит ссылки на них при посещении других ресурсов. Чтобы робот перестал обращаться к ненужным страницам, запретите их индексирование с помощью директивы Disallow в файле robots.txt .

Фильтрация данных

Информацию о страницах и изменениях в поисковой базе робота можно фильтровать по всем представленным параметрам (дате обхода, URL страницы, коду ответа сервера) с помощью значка . Ниже описано несколько примеров:

По ответу сервера

Можно составить список страниц, которые робот обошел, но не смог загрузить из-за ответа сервера 404 Not Found.

При этом можно выявить новые страницы, недоступные роботу, установив переключатель в положение Последние изменения :

А также - получить общий список страниц, недоступных роботу, установив переключатель в положение Все страницы :

По URL с указанием определенного фрагмента адреса

Можно составить список страниц, адрес которых содержит определенный фрагмент. Для этого выберите из списка значение Содержит и в поле укажите нужное значение.

По URL с указанием специальных символов

Специальные символы позволяют задавать не строгое соответствие строки, а ее начало, подстроку и более сложные условия с применением регулярных выражений. Чтобы использовать их, выберите из списка значение Условия , а само условие введите в поле. Можно добавить несколько условий - каждое из них должно начинаться с новой строки.

Для условий доступны правила:

- выполнять любое из условий (соответствует оператору «ИЛИ» );

- выполнять все условия (соответствует оператору «И» ).

| Символ | Описание | Пример |

|---|---|---|

| * | Использование символа * |

|

| @ | ||

| ~ | регулярному выражению | |

| ! | Отрицание условия |

| Символ | Описание | Пример |

|---|---|---|

| * | Соответствует любому количеству любых символов | Отобразить данные по всем страницам, которые начинаются с https://example.com/tariff/ , включая указанную страницу: /tariff/* Использование символа * Символ * может быть полезен при поиске URL, которые содержат два определенных элемента или более. Например, можно найти новости или анонсы за определенный год: /news/*/2017/ . |

| @ | Выбранные данные содержат указанную строку (но не обязательно строго соответствуют) | Отобразить данные по всем страницам, URL которых содержит указанную строку: @tariff |

| ~ | Условие является регулярным выражением | Отобразить данные по страницам, URL которых удовлетворяет регулярному выражению . Например, можно выбрать все страницы, в адресе которых есть одно или несколько упоминаний: ~table|sofa|bed |

| ! | Отрицание условия | Исключить данные по страницам, URL которых начинается со строки https://example.com/tariff/ : !/tariff/* |

При использовании символов не учитывается регистр.добавьте сайт в Яндекс.Вебмастер и подтвердите права на него. Также проверьте, не было ли сбоев на сервере. Если сервер выдает ошибку, робот прекращает индексирование и сделает следующую попытку в порядке общего обхода.

Сотрудники Яндекса не могут ускорить добавление страниц в поисковую базу.

Сколько времени надо ждать, чтобы сайт попал в Яндекс?

Мы не прогнозируем сроки индексирования сайтов и не даем гарантий, что тот или иной сайт будет проиндексирован. Как правило, от момента узнавания роботом о сайте до появления его страниц в результатах поиска проходит от нескольких дней до двух недель.

Вы пытались скачать секретную информацию с моего сервера. Что делать?

Робот берет ссылки с других страниц, а это значит, что на какой-то странице указаны ссылки на секретные разделы вашего сайта. Вы можете как закрыть их паролем, так и указать запрет для робота Яндекса в файле robots.txt . И в том, и в другом случае робот не будет скачивать секретную информацию.

Последние несколько месяцев выдача Яндекса стабильностью не радует. Во многих тематиках лидеры ТОПов меняются ежедневно, позиции в поиске постоянно скачут. Если сайт теряет трафик и места в выдаче, вебмастерам не всегда сразу понятно, что на самом деле происходит – понижен ли сайт за какое-то нарушение, или всему виной общий хаос в поиске. И чем дольше длится такая неопределённость, тем больше трафика, конверсий и дохода может потерять сайт.

В этой статье наш SEO-тимлид Евгений Аралов рассказывает, как самостоятельно диагностировать причины просадки сайта в Яндексе и что следует предпринять в каждом случае. Надеюсь, наши инструкция помогут вам остановить просадку и вернуться в ТОП.

Содержание статьи:

Постфильтр «Переоптимизация»

Запросонезависимый фильтр. Проявляется в виде резкой просадки группы запросов

на странице более чем на 20 позиций.

Постфильтр накладывается после того, как посчитано фактическое значение релевантности. Этот факт позволяет нам диагностировать фильтр с помощью операторов поиска – при их использовании постфильтр не срабатывает.

Диагностика:

1. Берём 5 сайтов, которые находятся выше пациента на 1–5 позиций;

2. Сравниваем релевантности с помощью следующего запроса:

[запрос] (site:пациент.ру |site: конкурент.ру)

.

3. Если более 3 сайтов конкурентов находятся ниже – переоптимизации нет

.

Все проверки необходимо проводить во вкладке «Инкогнито» (для браузера Chrome клавиши CTR+N, для Firefox – CTR+P).

Так же поступаем со всей группой запросов. Запросы должны быть в пределах ТОП-11-100.

В этом примере пациент находится ниже конкурентов в 5 из 5 случаев – можно говорить о переоптимизации.

Что делать, если диагностирована переоптимизация:

1) Сократить или полностью убрать текст;

2) Сократить количество вхождений во всех зонах документа вплоть до вхождений в коде документа (alt, атрибут Title у ссылок и картинок и т. д.);

3) Убрать выделение тегами , , и т. д.;

4) Если после нескольких апдейтов ситуация не изменится, необходимо сократить количество вхождений в анкорах внешних и внутренних ссылок.

Постфильтр «Переспам»

Запросозависимый фильтр, который проявляется в виде резкой просадки одного запроса или небольшой группы запросов на странице более чем на 30 позиций.

Диагностика:

Необходимо модифицировать просевший запрос и проверить по нему позиции. Если позиция выше, можно говорить о том, что на запрос наложен фильтр «Переспам».

Пример:

Продвигаемый запрос [сатиновые натяжные потолки] – 45 место

Модифицированный [сатиновый натяжной потолок] – 10 место

Что делать, если диагностирован фильтр «Переспам»:

Сократить количество вхождений просевшего запроса.

Алгоритм «Многорукий бандит» (рандомизация выдачи)

Ещё одной причиной потери позиций может быть понижение сайта относительно новым алгоритмом Яндекса «Многорукий бандит».

В 2015 году на конференции Optimization 2015 Яндекс объявил о внедрении нового алгоритма Multi-Armed Bandit.

Как работает?

Алгоритм подбрасывает документы в ТОП-10 (поднимает только полезные для пользователя документы (rel+)). После этого в течение некоторого времени Яндекс собирает статистику, на основе которой принимает решение оставить документ в ТОПе или понизить его.

Естественно, что исследуемый документ занимает чьё-то место, а случайный документ вываливается из ТОП-10.

Диагностика:

1. Главный признак действия алгоритма – скачки позиций между апдейтами. При этом изменение позиций имеет равное направление вниз или вверх.

Отслеживайте изменение позиций каждый день.

2. Если вы наблюдаете изменение между апдейтами, дополнительной проверкой может быть метод из пункта об «Переоптимизации».

Дело в том, что, как и в случае с «Переоптимизацией», действие алгоритма «Многорукий бандит» начинается после оценки релевантности, а значит, с помощью операторов поиска мы можем сформировать выдачу без постштрафов и постбонусов.

Что делать, если действует алгоритм «Бандит»:

Если вы поняли, что сайт понижен из-за «Бандита», контролируйте ситуацию: периодически проверяйте с помощью операторов, находится ли сайт выше сайтов-конкурентов. Если да, то ничего не предпринимайте. Алгоритм может действовать около 4-х месяцев.

На скриншоте можно увидеть небольшую группу запросов, которая резко просела в конце сентября. Позиции прыгали в течение 3-х месяцев, и в середине декабря запросы вернулись в ТОП – ситуация стабилизировалась. На странице ничего не меняли.

UPD:

Если скачки прекратились, но позиции не вернулись в ТОП и при попарном сравнении документ находится ниже конкурентов, необходимо проанализировать, насколько полно страница отвечает просевшим запросам и что можно улучшить. Проанализируйте ТОП и улучшите страницу.

Как предупредить ситуацию:

Прежде всего, контролируйте долю длинного клика по запросам.

Длинный клик – это время более 90 с и 180 с, которое пользователь провёл на сайте после перехода из поисковой системы по определённому запросу.

Желательно, чтобы доля длинных кликов по запросу превышала 15%. Если показатель ниже этого значения, необходимо принять меры по оптимизации страницы.

Для оценки этого показателя нужно составить специальный отчёт в Яндекс Метрике.

- Отчёты -> Источники -> Поисковые фразы (для Яндекса) и Отчёты > Поведение > Страницы входа (для Google)

- Сравнить сегменты -> C сегментом, заданным вручную

- Сегментация, для сегмента А (слева) задать -> Визиты, в которых -> Время на сайте -> 90, секунд. И: Последняя поисковая система: Яндекс*

- Для сегмента Б (справа): Последний источник -> Поисковая система: Яндекс или Google

* Рекомендуем отдельно анализировать «Яндекс, результаты поиска» и «Мобильный Яндекс»

В нашем примере доля длинных кликов по всем запросам составляет более 15%.

Также имеет смысл сравнивать поведенческие факторы своего сайта (страницы) с усреднёнными данными конкурентов по similarweb.com.

Пример таблицы сравнения:

В данном случае показатели нашего сайта должны быть приближены к значениям медианы.

Вылет из индекса посадочной страницы

Проявляется в виде резкой просадки позиций по всей группе запросов со сменой релевантности.

Проверить страницу на индексацию можно с помощью следующего запроса в Яндексе:

Если по вашему запросу ничего не нашлось, значит, страница не в индексе.

Что делать?

1. Выяснить причину. Чтобы выяснить причину, нужно зайти в Яндекс. Вебмастер -> Индексация -> Страницы в поиске;

Здесь вы увидите список удалённых страниц. Возле каждой страницы указана причина её удаления.

2. Исправить причину;

3. Отправить страницу на переобход. Яндекс. Вебмастер -> Индексирование -> Переобход страниц.

Официальные санкции Яндекса

Здесь имеются в виду официальные санкции поисковых систем. Основной симптом – резкое понижение всего сайта.

Диагностировать наложение таких санкций просто: достаточно зайти в Яндекс. Вебмастер -> Диагностика -> Безопасность и нарушения.

Совет

В Яндекс. Вебмастер оповещения могут приходить с задержкой. Если сайт полностью потерял позиции, а сообщения нет, рекомендуем писать в техподдержку.

Наиболее популярные санкции:

Минусинск – ограничивает сайты, которые используют SEO-ссылки. Лечится снятием покупных ссылок.

Санкции за накрутку поведенческих факторов – накладывается за эмуляцию действий пользователей с целью улучшения поведенческих факторов. Лечится отключением накрутки. Сроки выхода – не менее 9 месяцев.

АГС – накладывается за малополезный или неоригинальный контент, а также за продажу ссылок. Проявляется полным исключением страниц из поиска или аннулированием тИЦ. Лечится улучшением сайта и/или снятием ссылок.

Кликджекинг – ограничивает сайты, которые используют невидимые элементы, взаимодействие с которыми происходит без ведома пользователей (обычно для получения персональных данных).

Аффилирование

Фильтр, который накладывается на сайты одного владельца, продвигающиеся по одинаковым запросам.

Если Яндекс определил, что сайты являются аффилиатами, то по каждому запросу будет показываться только один из них.

Основные признаки сайтов-аффилиатов: одинаковые контакты, whois, одинаковые цены, структура и ассортимент и др.

Диагностика

Вариант 1

Если вы знаете, какой сайт может быть аффилирован, используйте следующий метод проверки:

Пропишите специальный запрос вида – если в выдаче останется только один из доменов, значит, действует аффилиат-фильтр.

Вариант 2

Если вы не знаете, какой сайт может быть аффилиатом, последовательно исключайте сайты из ТОП-30 и следите за позициями своего.

Если при исключении одного из сайтов позиции растут, значит, исключённый сайт и есть аффилиат.

Исключать сайты поможет следующая конструкция:

[запрос, по которому просели позиции] ~~ site:сайт-из-топа.ру

Что делать?

Сразу отмечу, что фильтр достаточно сложно снять. Основной задачей является уникализация ресурсов: смена контактных данных, смена структуры одного из сайтов, уникализация ассортимента, смена концепции.

Другие причины

Фильтр за одинаковые сниппеты

Накладывается, если сниппет страницы дублирует сниппет страницы конкурента, находящегося в ТОПе. В этом случае страница пропадает по продвигаемым запросам. Чаще наблюдается у карточек товаров, т. к. именно у них часто дублируется содержимое.

Чтобы обнаружить зафильтрованные страницы, необходимо в URL Яндекса в конце добавить переменную &rd=0.

Если вы обнаружили зафильтрованные страницы, уникализируйте фрагменты, которые идут в сниппет.

Смена региональности в Яндекс. Вебмастере

По разным причинам регион, присвоенный сайту в Яндекс.Вебмастере, может слететь или смениться другим, что, в свою очередь, часто приводит к потере позиций.

Проверить регион можно так: Яндекс. Вебмастер -> Информация о сайте -> Региональность.

Если регион не присвоен или присвоен нецелевой, то следует отправить ссылку на страницу с контактными данными Яндексу.

Мы рассмотрели наиболее популярные, но далеко не единственные причины, по которым могут просесть позиции.

Если у вас просели позиции сайта, прежде всего постарайтесь выявить закономерности и проанализировать ситуацию. Например, задайте себе такие вопросы:

- На каких страницах просели запросы: на карточках товара или на страницах категорий?

- Какие именно запросы просели: однословные, двухсловные, со словом «купить», геозависимые, коммерческие?

- Какая глубина просадки у разных групп запросов (если их несколько)?

- Позиция упала только у вас, или просела бόльшая часть ТОПа?

- Могут быть ли возникнуть ситуации, когда одна группа запросов просела из-за переоптимизации, а на другую группу действует «Многорукий бандит»?

Если ваш сайт просаживается в Яндексе или Google и вы не можете найти причину просадки, обратитесь к нам – мы разберёмся в ситуации и поможем вернуть позиции и трафик.

Много сказано уже про синдром 10 страниц в поиске Яндекса, но в последнее время эта «зараза» начинает распространяться и на качественные сайты СДЛ. Если раньше этот фильтр накладывался на сайты, которые грешили продажей ссылок и некачественным контентом, то сейчас я наблюдаю какую то модификацию этого фильтра от Яндекс.

Если в один прекрасный момент Вы заметили, что количество страниц в поиске осталось 50, 10 или меньше, то сайт находится под фильтром АГС.

Разберем пример как бороться с этим именно на примере качественного сайта, хотя алгоритм в целом будет одинаков как для СДЛ, так и ГС сайтов, за исключением того, что с ГС будет намного сложнее вытаскивать из подобного бана.

Почему это произошло?

Повторюсь, что мы рассматриваем пример, на котором не продаются ссылки и . Потому что если Вы грешите подобными вещами, то тут мне кажется ответ очевиден. В вашем случае надо снимать все внешние ссылки, менять текст на новый.

А вот если у вас ничего подобного не было, Вы развивали свой ресурс и добавляли новые страницы с качественным контентов и все равно фильтр Яндекса Вас не обошел стороной, то надо сделать анализ за последний месяц-два: посмотреть какие именно страницы вы добавляли. Потому что из существенных факторов, только это и могло повлиять.

В моем примере было сделано много страниц, которые заточены под определенные запросы по регионам Московской области. Допустим, мы продаем тапочки в Москве и области. Конкурировать с московскими бюджетами не имеет смысла, а вот по регионам данный товар идет хорошо.

Соответственно делаем под каждый регион свою страничку, на которой рассказывается что можно купить «тапочки в Клину» или «тапочки в Подольске» и так далее. Текст на каждой странице уникален, картинки тоже. Внешних ссылок не было. Но… в один момент на сайте осталось 10 страниц и стало уменьшаться. За это уже банят? Да, я конечно был удивлен, но надо было решать проблему.

Как вернуть все страницы в индекс Яндекса?

Во-первых: как только заметили, что в сайт проиндексирован на 10 или меньше страниц, то сразу пишем письмо Платону. Лучше всего это делать через панельку веб-мастера.

Он Вам ответит стандартным своим шаблонным письмом, обычно отвечают через3-5 дней:

Здравствуйте!

Извините за задержку с ответом.

Наши алгоритмы приняли решение ограничить индексирование Вашего сайта,

поскольку некоторые его страницы не соответствуют нашим представлениям о

качественных и, по нашему мнению, предназначены для обмана поисковой системы.

Наше понимание, чем качественный сайт отличается от некачественного, отражено

в следующих документах:http://help.yandex.ru/webmaster/?id=995342

http://webmaster.ya.ru/replies.xml?item_no=325&ncrnd=2022

Мы стараемся настраивать и улучшать алгоритмы поиска так, чтобы сайты,

соответствующие этим рекомендациями, быстро и полно индексировались и

находились на высоких позициях по релевантным запросам.

Когда все нарушения на сайте будут устранены, он сможет появиться в поиске в

более полном объёме.-

С уважением, Платон Щукин

Служба поддержки Яндексаhttp://help.yandex.ru/

Во-вторых: убрать все новые страницы. Это можно делать сразу после первого шага, что бы не терять время в пустую. Верните все до момента1,5-2месячной давности. Конечно, точно сложно сказать, до какого момента надо все вернуть назад, но вы должны понять, что именно повлияло на такое решение Яндекса и именно это убрать. В моем примере я сразу понял, что это были новые страницы с продажей тапочек, потому что другой работы по сайту не велось.

В-третьих: После того как получили ответ и все убрали, заново отвечаем на письмо Платона, где указываем, что все исправили и впредь будете аккуратнее. Теперь Ваш сайт чистый и пушистый.

В-четвертых: после проверки службой поддержки Яндекса вашего сайта Вам придет опять стандартное письмо:

Здравствуйте!

Благодарим за сообщение.

Причина, по которой Ваш сайт был запрещен к индексации, устранена. Окончательно вопрос о снятии санкций с сайта будет решаться через месяц.-

С уважением, Платон Щукин

Служба поддержки Яндексаhttp://help.yandex.ru/

Собственно это хороший знак. Через месяц ± 3 или 6 дней скорее всего сайт снова будет полностью проиндексирован. Но перед этим вполне возможно, что сайт вообще полностью вылетит из поиска и не будет проиндексировано ни одной странице. Пугаться не стоит, это нормально.

Вот так. Яндекс не стоит на месте и банит уже не только за ссылки, плохой контент но и за «спам» но я до сих пор не могу понять в чем заключалась суть спами…

Если есть вопросы, то задавайте в комментариях. Если Вам необходимо снова полностью вернуть сайт в индекс Яндекса, то обращайтесь, стоимость от 10 000 руб.

Загружаемая в браузере страница имеет собственный дизайн, размер и название шрифтов. Для людей с плохим зрением или просматривающих сайт на маленьком экране, может понадобиться увеличить масштаб экрана или наоборот, уменьшить.

В Яндекс Браузере, предусмотрено несколько способов изменения масштаба – от применения горячих клавиш, до выбора масштаба в настройках.

Как изменить масштаб экрана в Яндекс Браузере

Инструмент для изменения масштаба не зависит от того, хотите вы уменьшить или увеличить размер страницы. Главное различие способов – необходимо применить изменение для всех просматриваемых сайтов или для одного конкретного.

Давайте рассмотрим все способы, начиная с самых простых и заканчивая наиболее сложными.

После , все настройки для отдельно взятых сайтов – сотрутся.

Горячие клавиши на клавиатуре

Применив горячие клавиши, вы измените масштаб для одного конкретного сайта или страницы. Яндекс Браузер сохранит размеры и при следующем открытии, от вас не потребуется дополнительных действий.

1. Откройте в обозревателе необходимый сайт или страницу.

2. Зажмите клавишу «CTRL» и прокрутите колесо мыши:

- От себя – для увеличения масштаба;

- На себя – для уменьшения.

3. В это время, под адресной строкой обозревателя, появится окошко, информирующее об изменениях.

4. В качестве альтернативы, вы можете использовать комбинацию клавиш «CTRL +» и «CRTL –».

Окно настроек

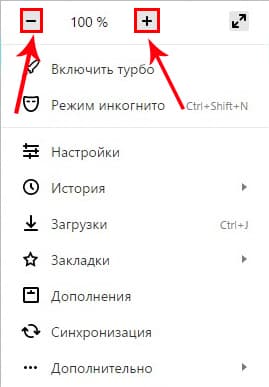

Аналогом горячих клавиш, выступает окно настроек, открыв которое, вы с той же легкостью измените масштаб.

1. Кликните на кнопку, с изображением трех горизонтальных линий.

2. С помощью кнопок «+» и «-» доведите размер страницы, до необходимого.

Как и при использовании предыдущего способа, поправки для этого сайта сохраняться.

Как отменить внесенные изменения

Все правки масштаба для отдельных сайтов, Яндекс Браузер сохраняет в отдельном файле, чтобы при следующей загрузке, страница отображалась с измененным размером.

Вернуть размер в прежнее состояние можно двумя способами:

- Использовать описанные выше средства;

- Удалив внесенные коррективы в настройках.

С первым пунктом не возникнет сложностей, а вот второй разберем подробнее.

1. В настройках Яндекс Браузера, найдите пункт «Личные данные».

2. Откройте «Настройки содержимого» и пролистайте страницу до конца.

3. Нажмите кнопку, указанную на скриншоте и удалите адрес ресурса, для которого необходимо вернуть масштаб в первоначальное состояние.

4. Нажмите на «Готово» и выйдите из настроек.

Изменение масштаба интерфейса браузера

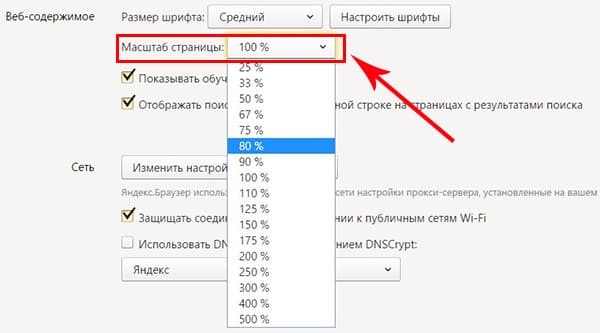

Для изменения размера всех загружаемых страниц и интерфейса Яндекс Браузера, требуется покопаться в настройках.

1. Перейдите в настройки обозревателя и найдите раздел «Веб-содержимое».

2. В пункте «Масштаб страницы», выберите нужный процент увеличения или уменьшения.

3. Продолжайте просмотр страниц, не перезагружая обозреватель.

Вот так, с помощью всего пары кнопок и нескольких секунд времени, вы можете, как уменьшить, так и увеличить масштаб страниц и интерфейса в Яндекс Браузере.

Поисковая оптимизация - большая работа над множеством различных факторов. Дизайн, техническая составляющая, контент. Даже незначительные на первый взгляд детали очень важны для продвижения. О самых частых ошибках в дизайне сайта мы уже говорили. Сегодня разберем 9 фатальных SEO ошибок, способных «угробить» любой сайт.

- Фильтры и санкции поисковых систем

Как минимум, раз в неделю рекомендую заглядывать в вебмастера Яндекс и Google для проверки наличия санкций. В Яндексе это можно сделать в разделе Диагностика → Безопасность и нарушения . В Google - Поисковый трафик → Меры, принятые вручную .

Как показывает наша практика, чаще всего владельцы сайтов даже не догадываются о наложенных ограничениях. Недавний пример из нашей работы:

Большое количество чужих текстов на сайте и открытые исходящие ссылки. Результат на скриншоте.

До снятия всех ограничений дальнейшего смысла заниматься продвижением нет. Исправляем все ошибки, сообщаем поисковой системе и ждем снятия санкций.

- Контент

Мы постоянно говорим о том, как важны тексты. Контент - это то, зачем пользователи заходят на сайты. Неуникальный и неинтересный контент никому не нужен. Поисковые системы занижают подобные ресурсы в выдаче, а клиенты устали читать одни и те же шаблонные тексты на сотне сайтов. Пруф того, что за контент можно вылететь с хороших позиций, .

Проверяйте уникальность текстов перед размещением на text.ru .

Как писать тексты, на какие страницы и в целом, о контенте, много написано в нашем блоге. Вот хорошая подборка статей от нашего копирайтера Дарьи.

- Теги Title и Description, заголовки H1-H3

Основа SEO-продвижения - правильно подобранные ключевые слова. Это очень важный фактор в оценке релевантности вашего сайта поисковому запросу.

Чаще всего мы сталкиваемся с двумя ошибками. Полное отсутствие ключевых слов в тегах:

Тег Title должен быть заполнен в виде связного предложения с включением ключевых слов.

Либо переспам ключами в заголовках:

Важно найти золотую середину. Теги должны быть полезными не только для поисковых роботов, но и для обычных людей. Не забывайте об информативности. Как правильно писать теги title, description и заголовки H1, хорошо рассказывает наш копирайтер Екатерина в своей статье .

- Переезд на https

C января 2017 года браузер Google Chrome (начиная с 56 версии) начал помечать все HTTP-сайты, содержащие любые формы, передающие личные данные пользователей (email, пароли, данные кредитных карт и т.п.) как «небезопасные». Также наличие SSL сертификата является небольшим импульсом в ранжировании в Google.

Всем интернет-магазинам в первую очередь следует перейти на протокол https. При этом очень важно соблюсти правильный алгоритм действий.

Самая частая ошибка - просто настроить 301-редирект со старой версии http на https после покупки SSL-сертификата. Владельцы сайтов забывают о файле robots.txt, директиве Host, настройке вебмастеров. Сайт с http выпадает из индекса, новый сайт на https еще не проиндексирован. Все позиции моментально улетают в трубу.

В нашем Блоге есть подробная инструкция , как правильно перенести сайт с http на https. Если останутся вопросы, пишите нам , обязательно поможем.

- Файл robots.txt

Текстовый файл, размещенный на сайте и предназначенный для роботов поисковых систем. В этом файле следует указать параметры индексирования своего сайта для поисковых роботов.

Иногда файл robots.txt отсутствует вовсе.

Свежий пример из нашей работы. Интернет-магазин станков, работы проводились в рамках услуги поисковое продвижение сайта . Сайт был полностью открыт для индексации поисковым роботам и вовсе не имел файл robots.txt.

Настроили ему robots, теперь все в порядке:

Что конкретно мы сделали?

Закрыли от индексации админ панель сайта, служебные страницы 404 и 403, страницу поиска, корзину. Указали адрес карты сайта, настроили директиву Host.

Вместе с остальными работами по оптимизации это помогло достичь следующих результатов:

Еще одна серьезная ошибка - сайт полностью закрыт от индексации. За это отвечают директивы Disallow и Allow, которые запрещают или разрешают индексирование разделов, отдельных страниц сайта или файлов соответственно. Для проверки файла у поисковых систем есть специальные инструменты: Яндекс и Google .

Проверьте, что у вашего сайта имеется файл robots.txt и заполнен он корректно. От индексации следует закрывать все служебные страницы, страницы поиска и фильтров. Страницы дублей, регистрации, авторизации. Корзину и страницу оформления заказа для интернет-магазинов. .

- Дублирование контента (дубли страниц)

Дублированный контент или просто дубли - это страницы на вашем сайте, которые полностью (четкие дубли) или частично (нечеткие дубли) совпадают друг с другом, но каждая из них имеет свой URL.

Одна страница может иметь как один, так и несколько дублей:

Поисковые роботы отрицательно относятся к дублированному контенту и могут понизить позиции в выдаче из-за отсутствия уникальности, а следовательно, и полезности для клиента. Нет смысла читать одно и то же на разных страницах сайта.

Может измениться релевантная страница. Робот может выбрать для выдачи дублированную страницу, если посчитает ее содержание более релевантным запросу. Сайт потеряет позиции и просядет в выдаче. В 90% случаев дубли мешают продвижению, и после их устранения позиции сайта улучшаются.

Как найти и убрать дубли на сайте, рассказываем в данной статье .

- Зеркала сайта

Зеркалами считаются сайты, являющиеся полными копиями друг друга, доступные по разным адресам. Все зеркала сайта важно склеить через 301 редирект.

Показатели тИЦ, вес внешних ссылок не должны растекаться, а они будут, т.к. поисковики считают разными ресурсами сайты, расположенные по разным адресам. Возможна подмена релевантной страницы в поисковой выдаче, дублирование контента. 100% мешает росту сайта в выдаче.

Сайт не должен открываться по разным адресам, с www и без www, просто site.ru и site.ru/index.php, по http и https и т.д.:

Чек-лист для проверки:

- Сайт должен быть доступен только по одному протоколу http или https.

- Выбрано главное зеркало сайта, с www или без www, указано в Вебмастере.

- Настроен 301 редирект со всех зеркал.

- Главная страница сайта доступна по одному адресу, без /index.php, /index.html и т.п.

- Адаптивная верстка (версия сайта для мобильных устройств)

100% Must-have для всех сайтов в 2017 году. Сегодня рост мобильного трафика опережает компьютерный. Число пользователей, использующих смартфоны для совершения покупок, в мире растет с каждым днем. Алгоритмы поисковых систем учитывают адаптивность при ранжировании сайта в мобильной выдаче.

Google уже с 2015 года использует алгоритм Google mobile-friendly .

- Скорость загрузки сайта

Тут все просто. Пользователям не нравятся медленные сайты. Поисковые системы так же отдают предпочтение быстрым, оптимизированным сайтам. Проверить скорость загрузки своего сайта можно с помощью инструмента Google . Красный - медленно, важно срочно увеличивать скорость, желтый - нормально, но можно оптимизировать, зеленый - отлично.

Разберем на конкретном примере

Помните, в начале статьи мы упоминали интернет-магазин станков. Что мы исправили из фатальных ошибок:

- Неуникальный контент

Написали хороший продающий, уникальный текст на главную страницу сайта.

- Ошибки оптимизации

Скорректировали теги title и description, заголовки H1.

- Отсутствие файла robots.txt

Создали и настроили файл robots.txt. Сейчас сайт правильно индексируется поисковыми системами. До этого, как писали выше, данного файла не было на сайте вовсе.

- Наличие не склеенных зеркал

Склеили зеркала сайта. Сайт был доступен по двум адресам с www и без.

- Некорректный ответ сервера для несуществующих страниц

Создали отдельную страницу 404 и настроили правильный ответ сервера для несуществующих страниц.

До выполнения работ несуществующие страницы через 302 редирект перенаправляли пользователя на главную страницу сайта.

Результаты:

Положительная динамика роста посещаемости из поисковых систем:

Трафик из Google вырос в два раза:

Результат за 3 месяца:

+8 запросов у Яндекса, +6 у Google в топ-5

+19 запросов у Яндекса, +9 у Google в топ-10

+25 запросов у Яндекса, +11 у Google в топ-20

+14 запросов у Яндекса, +4 у Google в топ-50

Хотите так же? Проверьте, может данные ошибки есть и на вашем сайте. Если нет времени и желания разбираться, заказывайте поисковое продвижение у нас, с радостью поможем.